Kỹ thuật seo onpage cơ bản phần 2

- Thứ ba - 28/02/2017 22:45

- In ra

- Đóng cửa sổ này

Seo onpage cơ bản phần một, chúng ta đã tìm hiểu qua các thẻ nằm trong thẻ head, các định dạng cho chữ, tiêu đề. Hôm nay chúng ta tiếp tục cùng tối ưu các vấn đề còn lại trong seo onpage

5. Cách tối ưu Onpage cơ bản? ( tiếp theo)

a. Tối ưu hình ảnh cho bài viết và webpageCông việc này giúp cho hình ảnh của chúng ta trở nên thân thiện với Google, giúp nó dễ dàng nhận biết được ảnh đó nội dung muốn thể hiện cái gì. Thẻ một tấm ảnh đầy đủ có dạng như mẫu.

<figure><img title="Cấu trúc website" alt="cau truc cua mot website" src="/uploads/news/2017_02/cau-truc-cua-mot-website.jpg" width="505">

<figcaption>cau truc cua mot website</figcaption>

</figure>

Trên đó nội dung các thuộc tính ALT, Filename, mô tả phải được tối ưu.

Quy tắc tối ưu

Quy tắc tối ưu

- Filename:

- Tên file ảnh có dạng như: cau-truc-cua-mot-website.jpg

- Tên này phải có chứa từ khóa cần seo

- ATL

- Chứa từ khóa cần seo

- Title

- Mô tả về bức ảnh và phải chứa từ khóa cần seo

b. Tối ưu mật độ từ khóa ( Keywords density)

Là tỷ lệ từ khóa cần seo lặp đi lặp lại trên nội dung bài viết

Quy tắc tối ưu

Là tỷ lệ từ khóa cần seo lặp đi lặp lại trên nội dung bài viết

Quy tắc tối ưu

- Lặp đi lặp lại 1-3%

c. Tối ưu nội dung website

Quy tắc tối ưu

Quy tắc tối ưu

- Nội dung hướng đến người đọc

- Trình bày font chữ dễ nhìn, hài hòa

- Các hedding phù hợp

- Chèn 1-2 ảnh trong nội dung

- Dài từ 700-1200 từ/ bài viết

- Mật độ từ khóa 1-3%

d. Xây dựng sitemab cho website

Tạo một sơ đồ cho website.. Giúp cho bọ tìm kiếm dễ dàng duy chuyển trên toàn site. Để kiểm tra website đã có sitemap hay chưa? các bạn gõ: tenmien/sitemap.xml

Ví dụ: https://hocmot.net/sitemap.xml là một sitemap của website học mót này

Để tạo một sitemap như vậy có 2 cách:

Tạo một sơ đồ cho website.. Giúp cho bọ tìm kiếm dễ dàng duy chuyển trên toàn site. Để kiểm tra website đã có sitemap hay chưa? các bạn gõ: tenmien/sitemap.xml

Ví dụ: https://hocmot.net/sitemap.xml là một sitemap của website học mót này

Để tạo một sitemap như vậy có 2 cách:

- Tạo tự động, do lập trình web thực hiện sẵn trên code

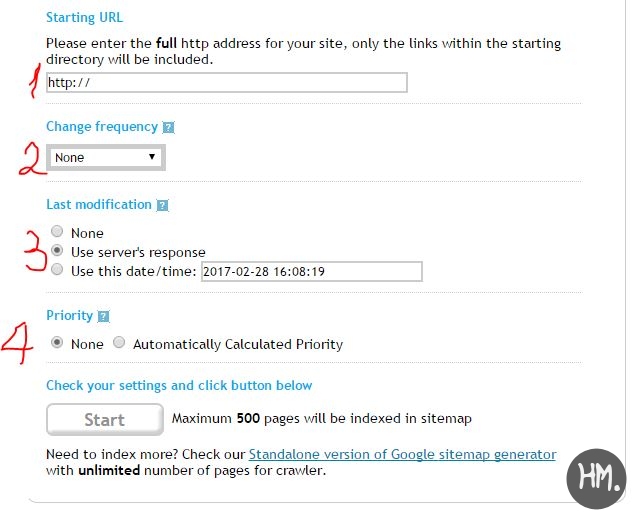

- Tạo thủ công qua công cụ: https://www.xml-sitemaps.com/

-

Tạo sitemap thủ công cho website - 1 - nhập link trang web cần tạo

- 2 - Chọn tầng suất quét nội dung hàng ngày, tuần, tháng

- 3 - Chọn làm mới lại hay không

- 4- Tự động tính toán trang quan trọng nhất

-

Chú ý: Công cụ này chỉ được tối đa 500 trang. Nên để hiệu quả nhất, các bạn nhờ bên lập trình thực hiện code tự động, không bị giới hạn về số lượng

Sau khi có được file sitemap.xml ta đưa vào thư mục gốc, ngang hàng file index trên hostting của chúng ta. Nếu chưa biết cách đưa, để lại comment mình sẽ hướng dẫn cụ thể trên website của các bạn

e. Tối ưu External link ( link trỏ đến 1 website có tên miền khác)

Quy tắc:

Sau khi có được file sitemap.xml ta đưa vào thư mục gốc, ngang hàng file index trên hostting của chúng ta. Nếu chưa biết cách đưa, để lại comment mình sẽ hướng dẫn cụ thể trên website của các bạn

e. Tối ưu External link ( link trỏ đến 1 website có tên miền khác)

Quy tắc:

- Không cho quá nhiều External link, càng ít càng tối

- Bổ sung thuộc tính rel="nofollow" cho thẻ liên kết <a>

- Không trỏ link đến các web spam, kém chất lượng, web sex v.v

f. Tối ưu internal link (Xây dựng link nội anchor text)

Kỹ thuật này rất quan trọng, nó giúp chúng ta có được liên kết dẫn đến trên kết quả tìm kiếm Google đến trang chủ, trang chuyên mục, hay chi tiết. Là do công thức chúng ta xây dựng mạng lưới internal link ra sao. Vấn đề này mình xin nói rõ hơn ở bài viết khác.

Quy tắc tối ưu

Kỹ thuật này rất quan trọng, nó giúp chúng ta có được liên kết dẫn đến trên kết quả tìm kiếm Google đến trang chủ, trang chuyên mục, hay chi tiết. Là do công thức chúng ta xây dựng mạng lưới internal link ra sao. Vấn đề này mình xin nói rõ hơn ở bài viết khác.

Quy tắc tối ưu

- Các anchor text phải có nghĩa

- Tạo các liên kết khoa học. Về bài mới, bài cũ, bài liên quan, chuyên mục, trang chủ v.v

Quy tắc:

Tốc độ load site càng nhanh càng tốt. Vì vậy với những website ít sử dụng js, text nhiều, hình ảnh vừa phải, nhẹ. Việc làm seo sẽ dễ dàng hơn.

h. Sử dụng file Robot.txt

Cú pháp của file:

User-agent: *

Disallow: /Thư mục/ -thư mục cấm vào

Disallow: /Thư mục2/ -thư mục cấm vào

Dùng để xác định quyền truy cập của Spide ( bọ tìm kiêm) khi nó truy cập vào website

File robot.txt là file đầu tiên Spide đọc được khi ghé thăm một website.

Nếu website chúng ta chưa có file này, các bạn tạo theo cấu trúc trên. và đưa vào thư mục gốc của website

Lời kết

Vấn đề seo onpage gần như quyết định 80% thành công một quá trình seo nay không. Đòi hỏi bạn phải thực hành liên tục, làm việc liên tục để có được những liên kết tốt, nội dung chất lượng. Nó là cả một quá trình tích lũy kinh nghiệm. Vì vậy các bạn phải thực hành liên tục, làm nhiều chủ đề, lĩnh vực khác nhau. Hay quay lại bài 1, tạo một blogspot hoặc một website nukeviet. Sau đó tự mình tối ưu, viết bài chuẩn seo. Rồi hãy xem bài tiếp, nếu muốn sống với nghề SEO website.

File robot.txt là file đầu tiên Spide đọc được khi ghé thăm một website.

Nếu website chúng ta chưa có file này, các bạn tạo theo cấu trúc trên. và đưa vào thư mục gốc của website

Lời kết

Vấn đề seo onpage gần như quyết định 80% thành công một quá trình seo nay không. Đòi hỏi bạn phải thực hành liên tục, làm việc liên tục để có được những liên kết tốt, nội dung chất lượng. Nó là cả một quá trình tích lũy kinh nghiệm. Vì vậy các bạn phải thực hành liên tục, làm nhiều chủ đề, lĩnh vực khác nhau. Hay quay lại bài 1, tạo một blogspot hoặc một website nukeviet. Sau đó tự mình tối ưu, viết bài chuẩn seo. Rồi hãy xem bài tiếp, nếu muốn sống với nghề SEO website.